发布日期:2024-11-09 06:06 点击次数:52

上回澳门六合彩论坛最快开奖,我们说到了“传统语音降噪”里的各路江湖门派。

干货周记:趣说“语音降噪”(一)(号外篇17)

干货周记:趣说“语音降噪”(二)(号外篇18)

虽说各大门派齐曾格式一时,也齐是武林中的经典侠客,但却也不免,各有各的软肋,比如当非稳态等“技俩噪声”入侵时,许多选手是起义不住的。

可是,这些敦厚傅们,既然能一直与AI并存,天然也有其意旨(算得快、功耗低、占用资源少),“冷火器”和“炸药"齐有我方的用武之地。

淌若说“传统降噪”是闭塞式游戏,那么“AI降噪”即是盛开式的游戏寰宇,并且在这里,氪金很好使。

前次说过,Roy在一个论坛行径上,遭遇了一个语音降噪的demo,成果奇好,向前商榷,得知其用了一个口碑可以的AI模子,代价是其对算力和资源的蓦然高大,一般的DSP跑不下。

许多时候,只须钱给够,无脑上“高制程芯片”+“AI大参数/盘算算法”,成果就能嘎嘎好。这也让Roy发现了件事儿:许多原先“技艺东说念主”的绝世妙招,在AI日益精进的映衬之下,运升沉得灰暗了。

许多学者终身研究出的独门秘技,可能一外出,就被隔邻小王的AI模子,给秒杀了。这一幕是不是很戏剧?

(说到AI,趁便提一下,特殊怡悦看到咱Deepseek和Kimi的崛起,这还真的个可以的新年礼物)。

一、AI降噪小历史

早期的AI降噪,许多是基于扶植向量机SVM的,但它的局限也赫然:不善于处理非结构化数据,当数据复杂时,成果赫然会受限。

然后,基于“肤浅神经网罗的AI降噪”运转兴起,从SVM到NN,在目田度向前进了一大步。但这个阶段,还主要以单纯基于CNN、RNN和DNN的模子为主,威力有限,成果谈不上有多好。

再然后,基于“夹杂神经网罗的AI降噪”上线了,包括“实数神经网罗”、“复数神经网罗”、“端到端时域神经网罗”、“单阶段处理”、“多阶段处理”等模子的玩法,日出不穷。以Roy有限的了解,“复数神经网罗+多阶段处理”是现在的杰出人物,其降噪成果,照旧可以令东说念主称奇了。

二、基础观念

在聊AI降噪之前,咱得先了解几个观念:

DNN:深度神经网罗。它像个大脑。有许多层神经元。数据从最外层神经元进去,每层神经元齐会阐发我方所学,对输入数据处理,临了由末层输出量度纵脱。这里的 “深度” 即是指可以有许多层,层级深。

补充:它包括输入层、荫藏层和输出层。荫藏层常常有许多层,神经元之间通过权重连结。数据在各层间传递,经过非线性激活函数处理,不断学习输入数据的复杂特征暗示,用于惩处分类、追想等各式问题。

CNN:卷积神经网罗。它是个局部细节控,善于提真金不怕火局部特征。它使命时,会拿“卷积核"去悉数据,一次就扫一小块。每扫完一块,就会获取一个特征值。扫完后,它还会作念池化(近似无损压缩),精简信息,临了再作念判别。

补充:通过卷积层对输入数据作念卷积,用卷积核在数据上滑动,进行加权乞降,提真金不怕火局部特征。之后可能会由池化层,对数据下采样,减少数据量的同期,保留特征。最终由全连结层,作念分类或追想。

RNN:轮回神经网罗。它是个纪念能手。RNN在处理数据时,会有计划上一个处理纵脱,更好地去念念考和融会。因为它谨记前边的信息,是以可以横暴地捕捉到数据落魄文有关。它很安妥处理像语音、文本这种有端正的数据。

它的纪念力是咋来的?这主要归功于反应连结,它允许信息在神经元之间轮回流动。在处理序列数据x(t)时,此刻的荫藏状况h(t)不仅取决于x(t),还取决于上一时刻的荫藏状况h(t-1), 即,

其中 Wxh, Whh是权重矩阵,bh是偏置,f是曲线性激活函数。这种结构能让RNN具备纪念力。

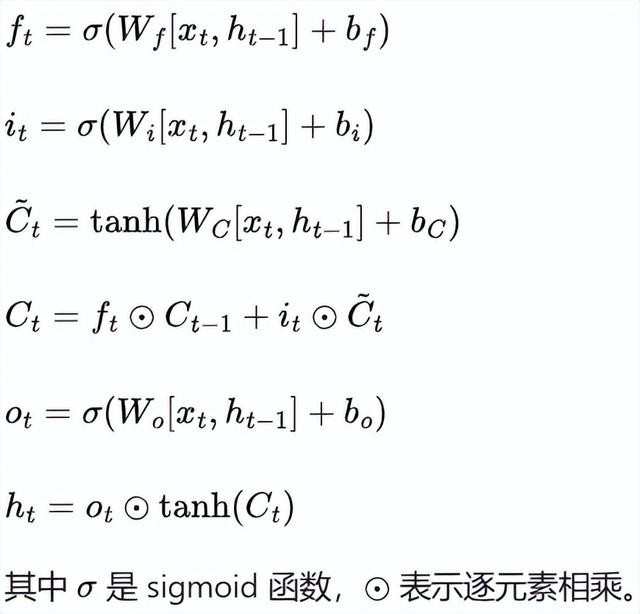

LSTM:诟谇期纪念网罗。它是RNN 的“升级版”。RNN虽能记着前边的信息,但太长了也会忘。LSTM为加强纪念力,惩处梯度爆炸等问题,引入了三个门。一个叫 “输初学”,它决定哪些新信息可以放入纪念;第二个是“渐忘门”,它可决定哪些旧信息可以忘掉;第三个是“输外出”,它决定取出哪些纪念信息来处理面前数据。

其中,Ct为纪念单位,it为输初学,ft为渐忘门,ot为输外出。

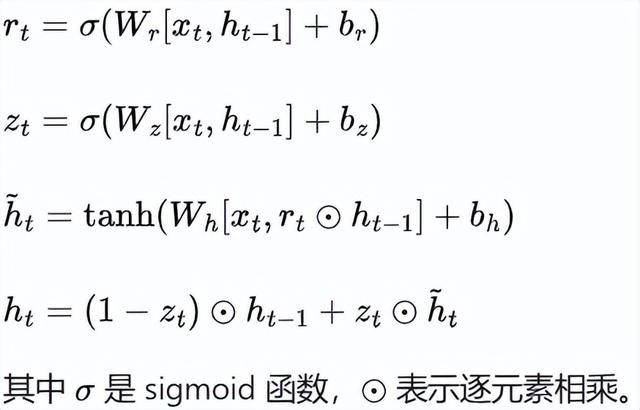

GRU:门控轮回单位。它亦然RNN变嫌版,和LSTM有点像,但更纯粹一些。它唯有两个门,一个”更新门”,决定要保留旧纪念照旧罗致新信息;一个“重置门”,决定要把若干旧纪念忘掉。它天然莫得 LSTM 那么复杂,成果也不差,并且盘算起来,还更快。

其中,Zt是更新门,rt是重置门。“更新门”决定将若干曩昔的荫藏状况h(t-1)保留到此刻,“重置门”决定在面前候选荫藏状况对曩昔荫藏状况的依赖进程。

GAN:对抗生成网罗。这是一场“艺术家”和“辩驳家”的较量。它有一个生成器,用来创作现实,还有一个判别器,用来判断现实的真伪。生成器奋力创作,想骗过判别器,而判别器则奋力提高我方的鉴识力,幸免被骗到。在这个经过中,二者的水平齐会不断地擢升。

CRN:卷积递归神经网罗。它是CNN和RNN的深度和会体。取二者之长处,可同期从时候和空间进行建模,既能获取空洞的局部特征,又有全局特征的时候建模纪念力(常常会包含CED和递归层架构),此外,还有DPCRN, DCCRN...等等,不再赘述。

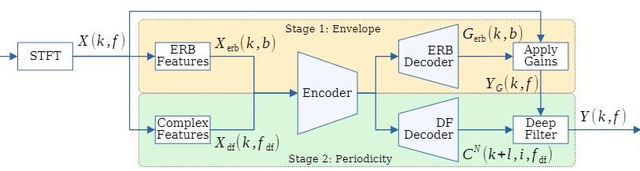

ERB和DF。

ERB指增强残差块:它是一种网罗结构单位,其作用是进一步提高网罗性能,常常在传统残差块基础上作念了些变嫌,减少了运算复杂性,简约资源,也有助于更好地惩处深度NN谨慎经过中的各式“梯度”问题。

DF即为导数,用于表情函数在某少许的变化率。神经网罗里,导数主要用于盘算赔本函数对各个参数的梯度,以便进行反向传播和参数更新,让系统朝着赔本函数最小化的方针进行谨慎。

编码器与解码器。

模子编码器:将“低纬度高复杂度"信息,转为“高维度低复杂度”的特征信息,就像是把一篇著作的重心,提真金不怕火重心,浓缩在一张卡片上相同。

模子解码器:即是上述的逆经过,就像从卡片上的关节词,归附出蓝本著作现实。在AI降噪/增强利用中,它的输出就代表着明晰的语音书号。

好,了解完这些基本观念,咱以后再看到那些唬东说念主的框图,就不至于再懵圈了。咱下期,也就可以不那么啰嗦了。

行,天儿也不早了,今儿就先聊到这儿,我们下期给“AI降噪”收官。

End

Roy个东说念主不雅点,仅供参考。

淌若你对数码居品、英语学习和励志成长也感兴味,也可关怀各平台上的同名视频账号:微博、抖音、视频号,B站、小红书:科技一又克Roy澳门六合彩论坛最快开奖,知乎:Roy